Il ne suffit pas d'avoir l'air intelligent : comment rendre l'apprentissage automatique plus sûr?

Depuis le lancement de ChatGPT il y a tout juste trois ans, l'intelligence artificielle (IA) domine les conversations et les investissements à un degré sans précédent. Ce modèle a pulvérisé tous les records précédents en matière d'interaction homme-machine, devenant la plateforme la plus rapide à atteindre le million d'utilisateurs. Les tendances actuelles indiquent que l'IA est en train d'être rapidement intégrée dans presque tous les appareils que nous utilisons, des smartphones aux machines à laver. Mais une question se pose de plus en plus : est-il sûr de s'appuyer autant sur cette technologie, compte tenu de ses lacunes connues ?

Nous savons que les modèles d'IA sont sujets à des « hallucinations » : des déclarations qui semblent corrects mais qui sont en réalité faux. Le plus inquiétant, c'est que les modèles d'IA sont souvent extrêmement sûrs de ces réponses erronées ou, à l'inverse, tellement crédules qu'ils sont d'accord avec tout ce que dit l'utilisateur, juste pour le satisfaire. Le chatbot donne d'abord une réponse qui semble convaincante, puis reconnaît que sa première affirmation était erronée... une correction qui arrive peut-être un peu trop tard. Si vous utilisez régulièrement des modèles d'IA, vous avez peut-être déjà observé ce phénomène.

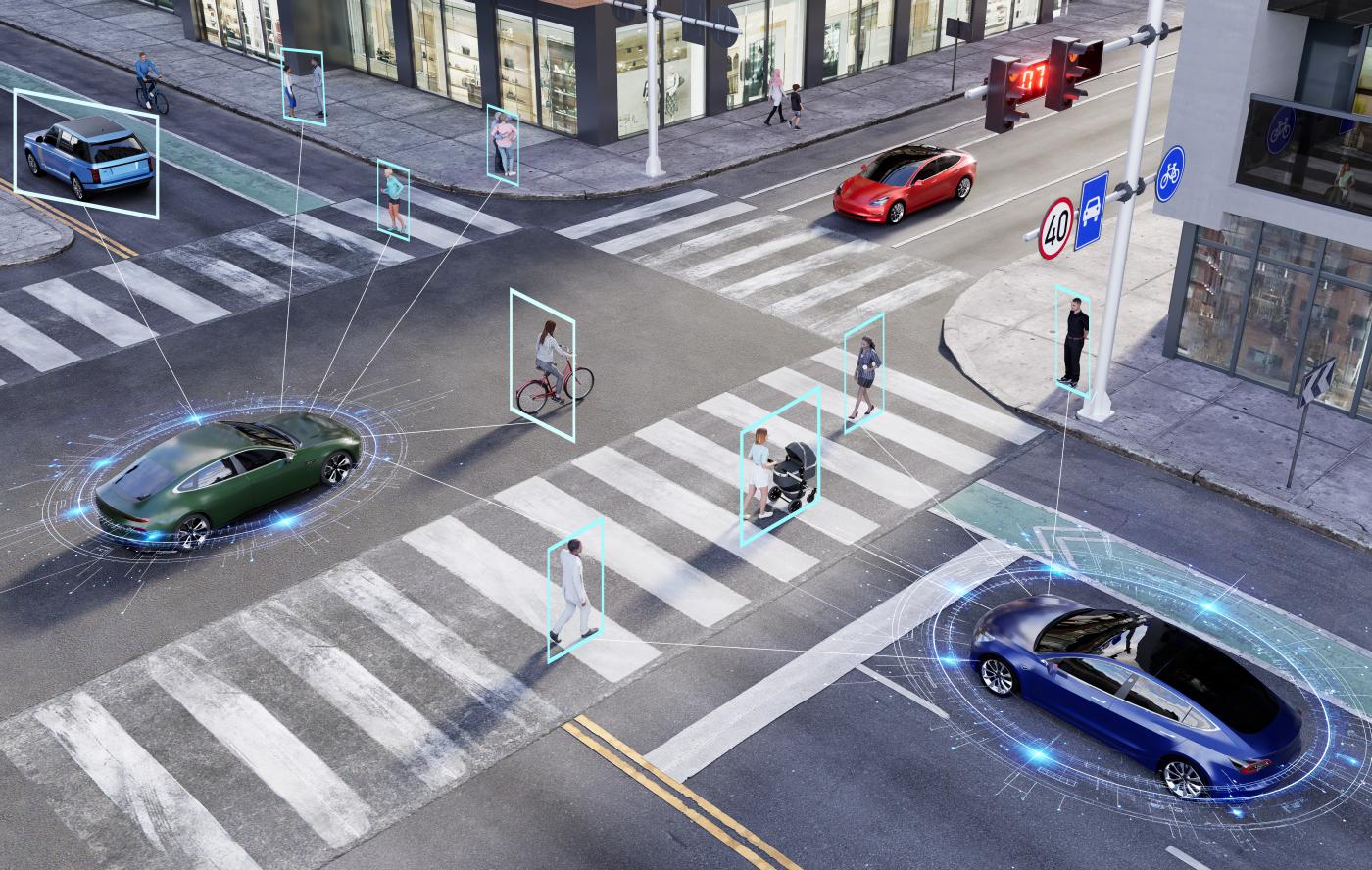

Les mêmes préoccupations en matière de fiabilité s'étendent aux systèmes d'IA basés sur la vision, qui « voient » et interprètent les images, qu'il s'agisse de distinguer un chat d'un chien, de reconnaître la plaque d'immatriculation d'une voiture à un carrefour ou, à l'avenir, de permettre à des robots domestiques ou à des véhicules autonomes de transporter des enfants à l'école. Si ces applications s'appuient sur la perception visuelle, tout comme les humains, les systèmes d'IA sont beaucoup plus fragiles.

Les modèles d'apprentissage automatique, qui constituent la base de l'IA, peuvent être étonnamment vulnérables à des modifications même mineures de leurs données d'entrée. Cette vulnérabilité a été observée pour la première fois dans l'apprentissage automatique classique : l'introduction d'une infime quantité de bruit soigneusement conçue dans une image peut amener le modèle à la classer de manière erronée, souvent avec un haut degré de confiance. Par exemple, un outil d'IA peut identifier correctement un panda dans une image, mais après avoir ajouté un bruit subtil et artificiel, il étiquette à tort la même image comme un gibbon. De même, de petites taches sur un panneau stop peuvent tromper une IA et lui faire percevoir ce panneau comme un panneau de limitation de vitesse.

Ce phénomène est connu sous le nom de robustesse antagoniste. Bien qu'il puisse sembler s'agir d'un défaut mineur, ses implications sont graves. Imaginez qu'une voiture autonome interprète à tort un panneau « Stop » comme un panneau de limitation de vitesse : une telle erreur pourrait entraîner des accidents catastrophiques. Cette fragilité rend les modèles d'IA actuels peu fiables pour les applications critiques en matière de sécurité.

Un apprentissage fiable

Au cours de mon doctorat, j'ai étudié l'apprentissage automatique sous l'angle de la théorie des systèmes et du contrôle. Il s'agit du même domaine des mathématiques et de l'ingénierie qui permet aux avions de voler de manière stable grâce au pilote automatique, qui maintient la température de nos pièces au niveau de confort voulu, qui fait fonctionner les chaînes de montage automobiles et qui garantit que les satellites continuent de tourner autour de la Terre sur leur trajectoire correcte.

Son succès est le fruit de décennies de développement mathématique rigoureux. La motivation principale de nos recherches découle des parallèles récemment découverts entre l'apprentissage automatique et le domaine bien établi de la théorie des systèmes. Ce lien a ouvert de nouvelles possibilités pour analyser ces systèmes opaques à l'aide d'une multitude d'outils développés au fil des décennies. Ainsi, sous la direction de mon superviseur, le professeur Giancarlo Ferrari Trecate, j'ai décidé de réunir l'apprentissage automatique et la théorie du contrôle. Le résultat est ce que nous appelons l'apprentissage automatique fiable.

Par « fiable », nous entendons qu'un modèle d'apprentissage automatique doit se comporter comme prévu, même dans des scénarios qu'il n'a jamais rencontrés auparavant, et être soutenu par des garanties mathématiques solides. Cela ouvre la voie à une IA interprétable, dont le comportement est limité dans des situations inconnues, et qui peut finalement être utilisée en toute sécurité dans des applications critiques.

Bien sûr, la « fiabilité » peut avoir différentes significations selon le contexte. Par exemple, garantir la stabilité d'un avion malgré les rafales de vent, construire des modèles d'apprentissage automatique d'une usine chimique qui respectent toujours les lois de la chimie, ou concevoir un chatbot qui n’hallucine pas. Les chercheurs ont essayé de rendre l'IA plus fiable en utilisant des méthodes conventionnelles telles que la contrainte des paramètres des modèles ou la restriction de leurs résultats. Si ces approches peuvent être utiles, elles ajoutent souvent une lourde charge de calcul ou ne garantissent pas rigoureusement la fiabilité.

La méthode traditionnelle pour amener un réseau neuronal à respecter des contraintes définies (telles que les lois de la thermodynamique, la stabilité, etc.) consiste à promouvoir le comportement souhaité par le biais de la fonction de perte, c'est-à-dire en intégrant une pénalité (ou une récompense). Le réseau tentera alors d'optimiser sa sortie en fonction de cette fonction. Cependant, la pénalisation de cette fonction dite de récompense ne garantit pas que l'on obtiendra la même récompense pour les échantillons invisibles à l'avenir.

Pour remédier à cela, nous avons exploré le concept de paramétrage libre. En termes simples, cela signifie concevoir des modèles de telle sorte que, quelle que soit la manière dont vous réglez les paramètres, le réseau neuronal respectera automatiquement les propriétés souhaitées. L'utilisateur peut définir librement les paramètres afin de s'assurer que l'objectif sera atteint dès la conception. En conséquence, le réseau a besoin d'effectuer beaucoup moins de calculs ; ce modèle est donc non seulement plus fiable, mais aussi beaucoup plus évolutif et économe en énergie.

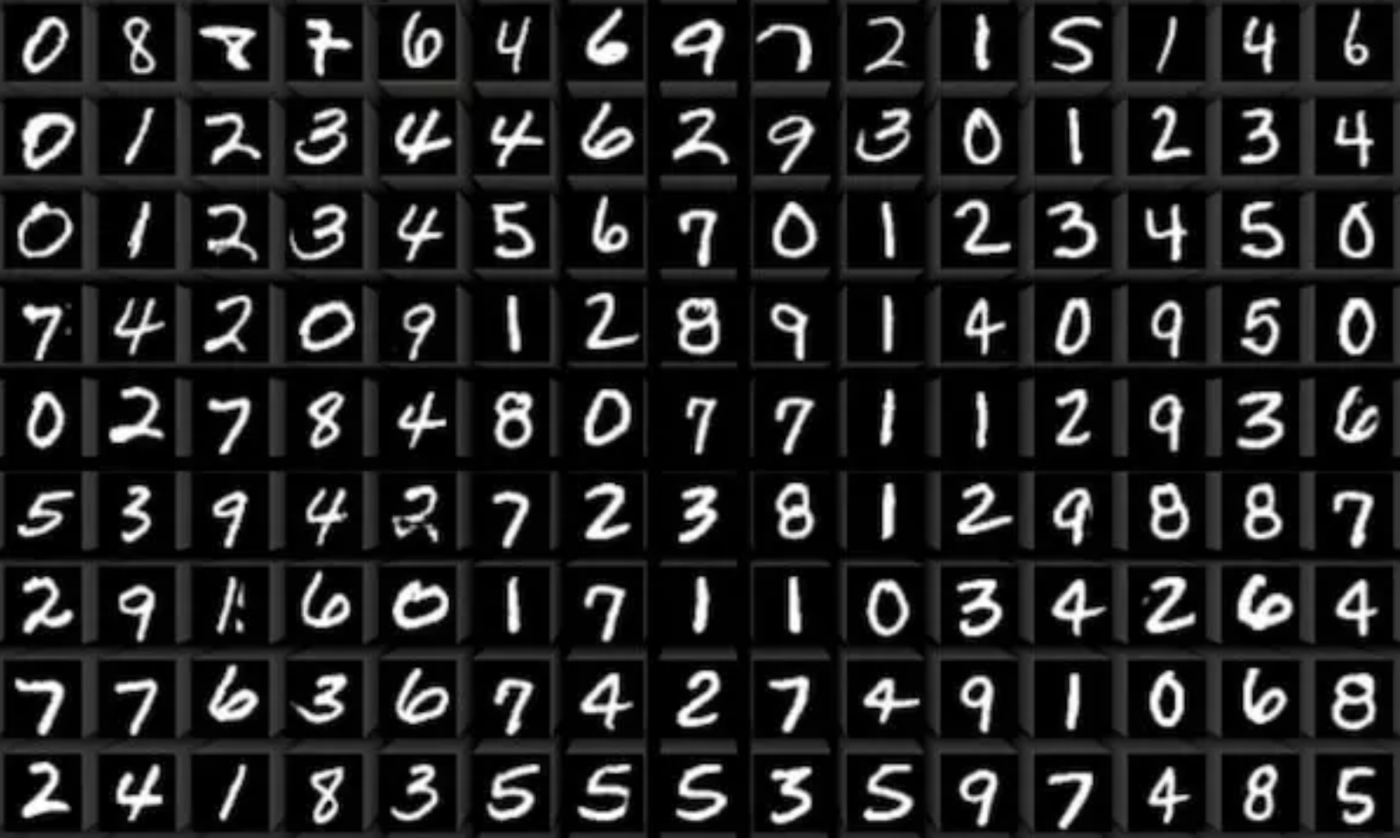

Au cours de mon doctorat, nous avons appliqué ces idées dans plusieurs cadres. Un exemple consiste à rendre les modèles d'IA plus robustes dans les tâches de classification d'images. La classification d'images (apprendre à un modèle à étiqueter des images) est au cœur de nombreuses applications concrètes : de la vision dans les robots et les voitures autonomes à la reconnaissance de l'écriture manuscrite et à la numérisation de livres anciens.

Mais une IA fiable va bien au-delà de la classification d'images. Prenons un exemple aussi banal que la prévision de la température dans votre appartement. Cela peut sembler simple, mais de nombreux facteurs influencent la température : l'angle du soleil, la disposition des meubles, la façon dont les pièces partagent les murs, le temps extérieur et même la saison. Écrire un modèle exact pour tout cela est non seulement fastidieux, mais nécessite également une expertise approfondie. Bien que nous connaissions les lois de la thermodynamique, nous ne disposons pas d'un moyen simple de les combiner avec des modèles d'IA.

C'est là que notre travail entre en jeu. Nous avons intégré les lois physiques directement dans la structure des modèles d'apprentissage automatique, afin qu'ils respectent toujours les lois de la physique, quels que soient les paramètres. Nous avons appelé ces modèles « modèles cohérents avec la physique ». Nos expériences ont montré que ces modèles pouvaient prédire de manière fiable la température d'un appartement jusqu'à trois jours à l'avance, ce qui permettait de mieux contrôler le chauffage et la climatisation. Cela signifie une économie d'énergie et, en fin de compte, une contribution à la protection de la planète. Cette expérience a été menée dans le cadre d'une collaboration fructueuse avec le professeur Colin Jones et Loris di Natale.

L'apprentissage fiable ouvre la voie à une IA digne de confiance qui peut être déployée en toute sécurité dans notre vie quotidienne, même dans des applications critiques pour la sécurité. En fusionnant l'apprentissage automatique et la théorie du contrôle, nous pouvons exploiter les atouts des deux : l'expressivité et la capacité de généralisation de l'IA, combinées aux garanties rigoureuses de la théorie du contrôle. Nous pensons que ce cadre jette les bases d'une IA interprétable et sûre.