Zurück zu dem, was wir wissen: Physikalische Erkenntnisse in neuronale Netze einspeisen

Neuronale Netze (NN) - eine Art künstliche Intelligenz - können Menschen in Go schlagen, die 3D-Struktur von Proteinen vorhersagen oder komplexe Fragen überzeugend beantworten. Doch trotz dieser grossen Erfolge können NNs aufgrund des Phänomens des Abkürzungslernens auch recht spektakulär scheitern. Manchmal gelingt es ihnen, die Aufgabe auf unerwartete Weise zu lösen, zum Beispiel die Unterscheidung zwischen Hunden und Katzen anhand des Vorhandenseins oder Nichtvorhandenseins einer Leine. Das funktioniert zwar bis zu einem gewissen Grad, aber es entspricht nicht unserer menschlichen Intuition. Wir wissen, dass das nicht der wirkliche Unterschied zwischen Katzen und Hunden ist, und es wird nicht immer funktionieren.

Das Problem ist, dass NNs keine Rückmeldung darüber geben, was sie tun - es gibt keine allgemeine Möglichkeit für Menschen, Fehler von NNs zu erkennen, was in der Praxis die Interpretation erschwert. Und wenn man eine solche Abkürzung zulässt, könnte das bedeuten, dass später grössere Fehler auftauchen. Wenn das NN beispielsweise die Aufgabe hätte, Ratschläge für die medizinische Versorgung des identifizierten Tieres zu erteilen, wäre es ziemlich wichtig, zuverlässig zu wissen, welches Tier welches ist. Und die gleiche Art von Schwäche führt zu Risiken für den Menschen, wenn NNs zur Modellierung oder Steuerung von (potenziell sicherheitskritischen) physikalischen Systemen wie Gebäudeheizungen eingesetzt werden, so dass dieses Problem dringend behoben werden muss.

Wie kommt es also zu solchen Fehlern - und wie können wir sie verhindern? Beginnen wir ganz am Anfang.

Ein neuronales Netz, was ist das?

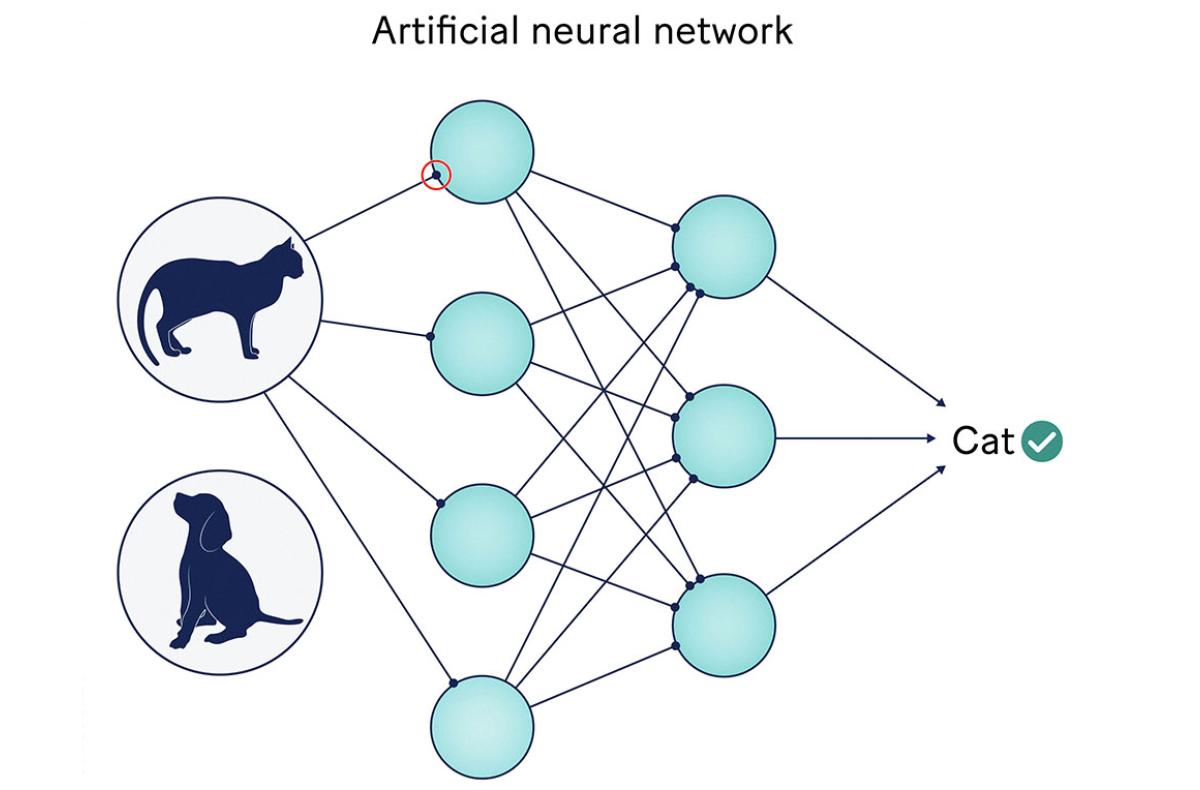

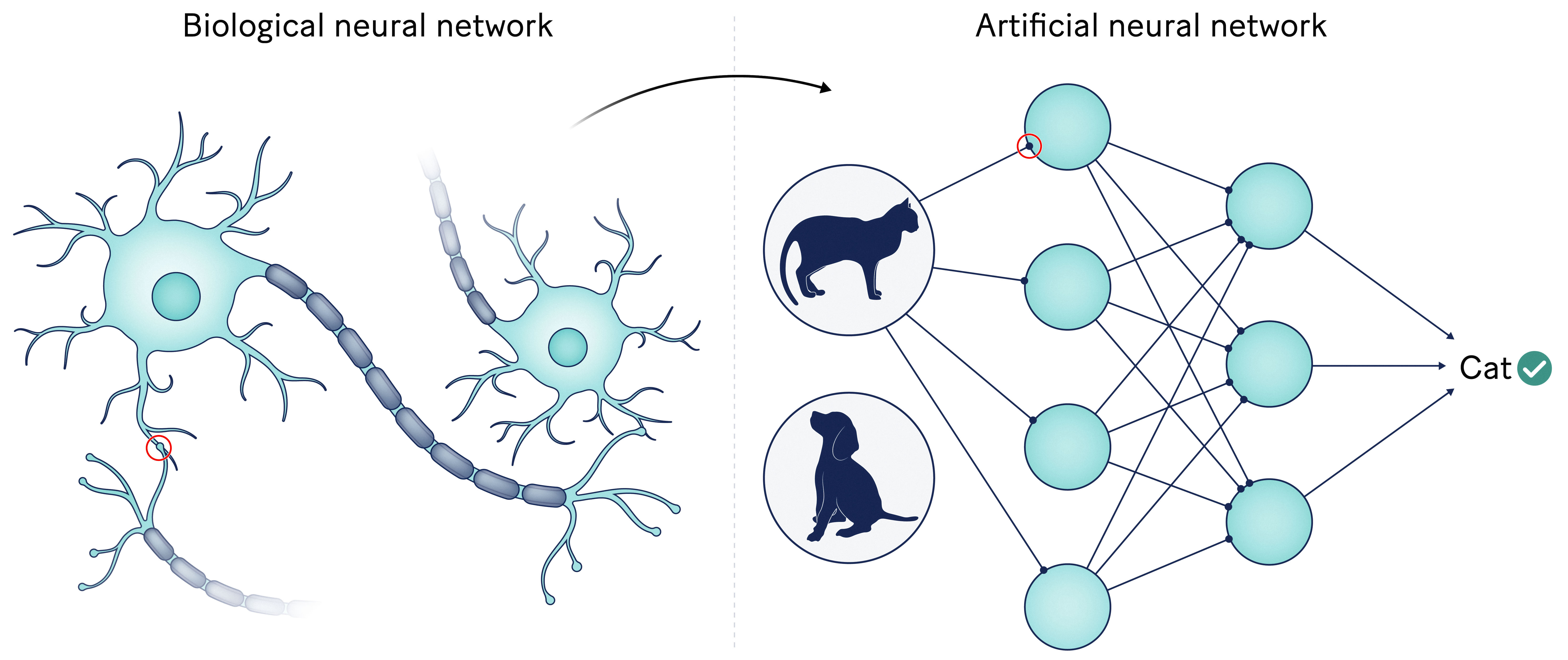

Die Entwicklung von NN zielt darauf ab, das menschliche Gehirn nachzubilden. Als solche bestehen NNs aus einer Reihe von Neuronen (in der Regel in Schichten organisiert) und Verbindungen (analog zu den Synapsen im menschlichen Gehirn). Natürlich sind die Neuronen hier mathematische Funktionen und keine Nerven... aber das ist die Idee. Ein NN nimmt einige Daten (z. B. ein Bild) als Eingabe und leitet sie durch das Netz. Jedes Neuron aggregiert und transformiert die Daten, die es von anderen Neuronen erhält, bevor es sie an die nächsten Neuronen weiterleitet. Am Ende des Prozesses gibt das NN ein Ergebnis aus (z. B. "Katze" oder "Hund").

Hier kommt die Magie der NNs ins Spiel und der Grund, warum sie überall eingesetzt werden: Wir können sie trainieren, um ein bestimmtes Ziel zu erreichen (hier die Unterscheidung zwischen Katzen und Hunden)! Mit anderen Worten: Wir wissen, wie wir die Neuronen und Verbindungen der NNs so lange verändern können, bis sie die gewünschte Aufgabe erfüllen. Ganz schön raffiniert, oder?

Diese vom Gehirn inspirierte komplexe vernetzte Struktur ist gleichzeitig die grösste Stärke und der größte Nachteil von NNs: Sie ermöglicht es ihnen, bei vielen Aufgaben übermenschliche Leistungen zu erbringen, macht es aber im Grunde unmöglich, sie zu verstehen oder gar zu interpretieren. Schliesslich verstehen wir auch nicht wirklich, wie sich unser eigenes Gehirn verhält. Aus diesem Grund werden NNs oft als Black-Box-Modelle bezeichnet: Wenn man mit NNs arbeitet, gibt man ihnen in der Tat eine Eingabe und beobachtet die Ausgabe - ohne wirklich zu wissen, was in der Mitte passiert!

Wir verstehen nicht, warum NNs funktionieren, aber warum sollte uns das interessieren?

Das ist in der Tat eine gute Frage: Wenn NNs funktionieren, warum sollten wir uns darum kümmern, warum oder wie?

Nun, da wir nicht wissen, warum sie funktionieren, bedeutet dies auch, dass wir keine Ahnung haben, warum oder - was vielleicht noch wichtiger ist - wann sie versagen werden. Und das werden sie höchstwahrscheinlich.

Eine Katze fälschlicherweise als Hund zu klassifizieren, mag zwar nicht schlimm sein, kann aber schnell unethisch oder gefährlich werden, wenn Menschen betroffen sind. Sie möchten doch nicht ein Jobangebot verpassen, nur weil irgendein NN fälschlicherweise entschieden hat, Ihr Lebenslauf sei nicht gut genug. Und das ist noch bevor man Probleme wie autonome Autounfälle in Betracht zieht...

Die Sache ist die, dass Interaktionen mit Menschen in vielen Anwendungen unvermeidlich sind - insbesondere bei der Arbeit mit physikalischen Systemen. Wir brauchen Lösungen, um zu kontrollieren, was neuronale Netze in der Praxis tun.

Unsere jüngsten Analysen haben zum Beispiel das Problem des Lernens von Abkürzungen bei der Modellierung der Temperatur in einem Gebäude aufgezeigt. Einige klassische Black-Box-NNs waren tatsächlich in der Lage, die Temperatur sehr gut vorherzusagen - allerdings ohne Berücksichtigung der Energiezufuhr! Mit anderen Worten, für diese NNs hat das Beheizen oder Kühlen eines Raumes absolut keinen Einfluss auf die Temperatur. Sie beobachteten zwar einige Korrelationen in den Daten, verstanden aber die Kausalität nicht - die Ereigniskette, die mit dem kalten Wetter draußen begann und dazu führte, dass die Heizungssysteme aktiviert wurden, was wiederum Temperaturänderungen im Gebäude zur Folge hatte, ging an ihnen vorbei.

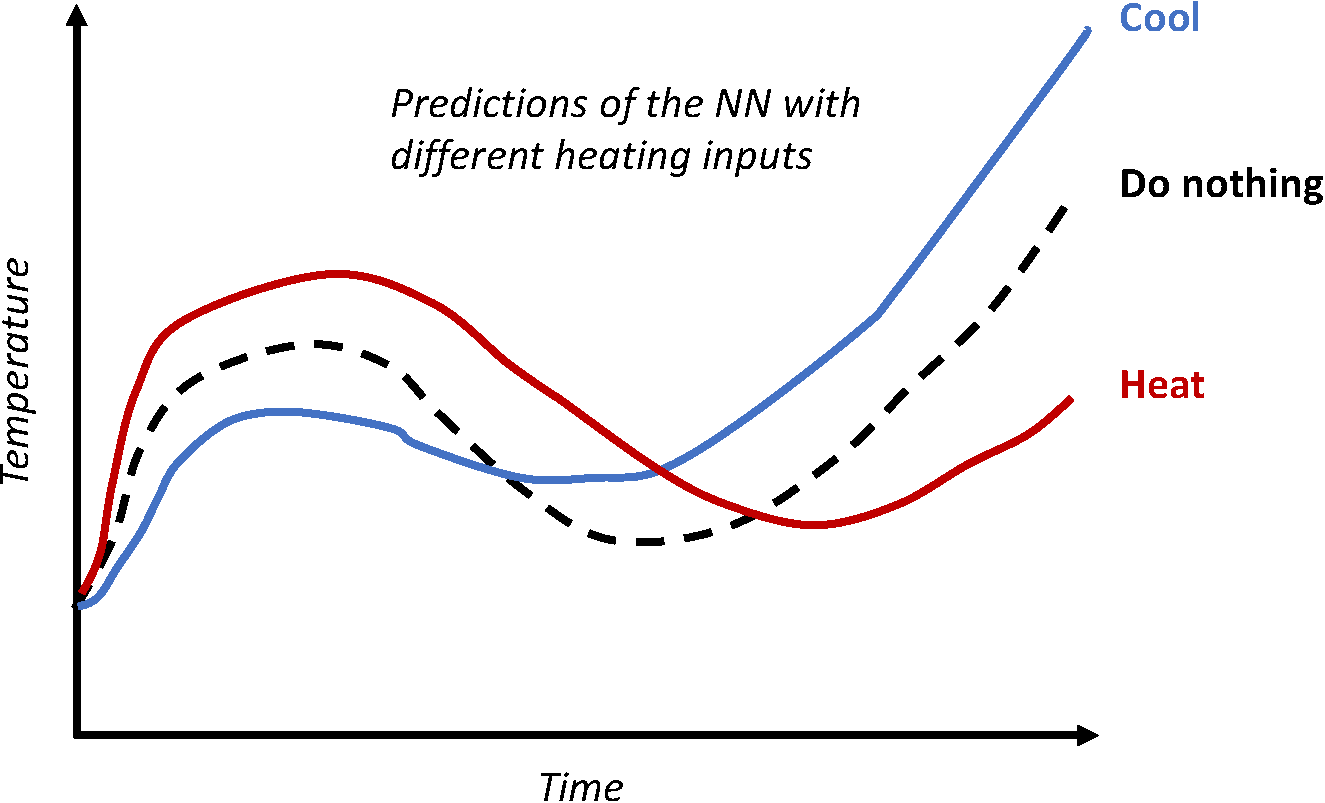

Wir fanden sogar heraus, dass einige der trainierten NNs manchmal dazu neigten, die Gesetze der Thermodynamik komplett umzukehren und dachten, dass das Heizen eines Gebäudes letztendlich zu niedrigeren Temperaturen führen könnte als das Kühlen (Abbildung 2)! Das ist ziemlich lustig, aber nicht sehr praktisch - es sei denn, wir haben gerade eine künstliche Intelligenz geschaffen, die in der Lage ist, die physikalischen Gesetze unserer Welt neu zu schreiben.

Das bedeutet natürlich, dass ein solches fehlerhaftes NN zum Beispiel für die Steuerung der Gebäudetemperaturen unbrauchbar ist. Da es nicht versteht, was Heizen bewirkt, wird es das Gebäude vielleicht nie anweisen, die Heizung den ganzen Winter über laufen zu lassen, egal wie tief der Schnee draußen liegt.

Und solange man ihm nicht das richtige Verhalten beibringt, hat das NN keine Möglichkeit zu verstehen, dass es etwas falsch gemacht hat! Das Schlimmste daran ist, dass es sich seiner Fehler nicht bewusst ist und keine Rückmeldung über sein Verhalten gibt. Und wenn ein Ingenieur nie merkt, dass mit seinem Modell etwas nicht stimmt, kann das zu den oben erwähnten ethischen oder physischen Gefahren führen.

Physikalisch konsistente neuronale Netze

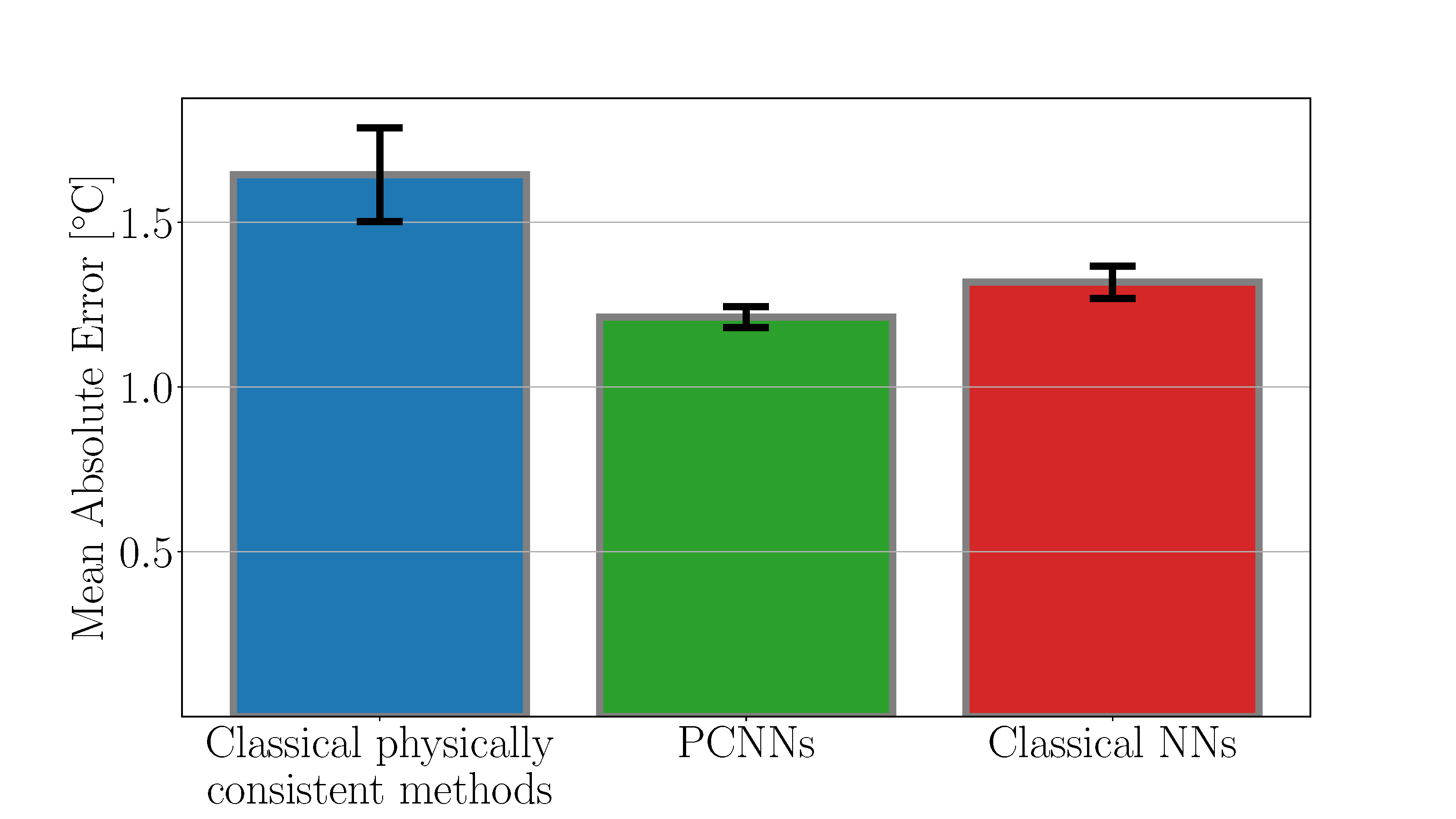

Andererseits sind die Gesetze der Thermodynamik seit Jahrzehnten bekannt, so dass wir Modelle entwerfen können, die auf der zugrundeliegenden Physik basieren - und daher von vornherein korrekt sind. Der Nachteil ist natürlich, dass sie viel ungenauer sind als neuronale Netze, die durch ihre vielen Verbindungen hochkomplexe Phänomene erfassen können. Wäre es nicht toll, wenn wir das Beste aus beiden Welten herausholen könnten?

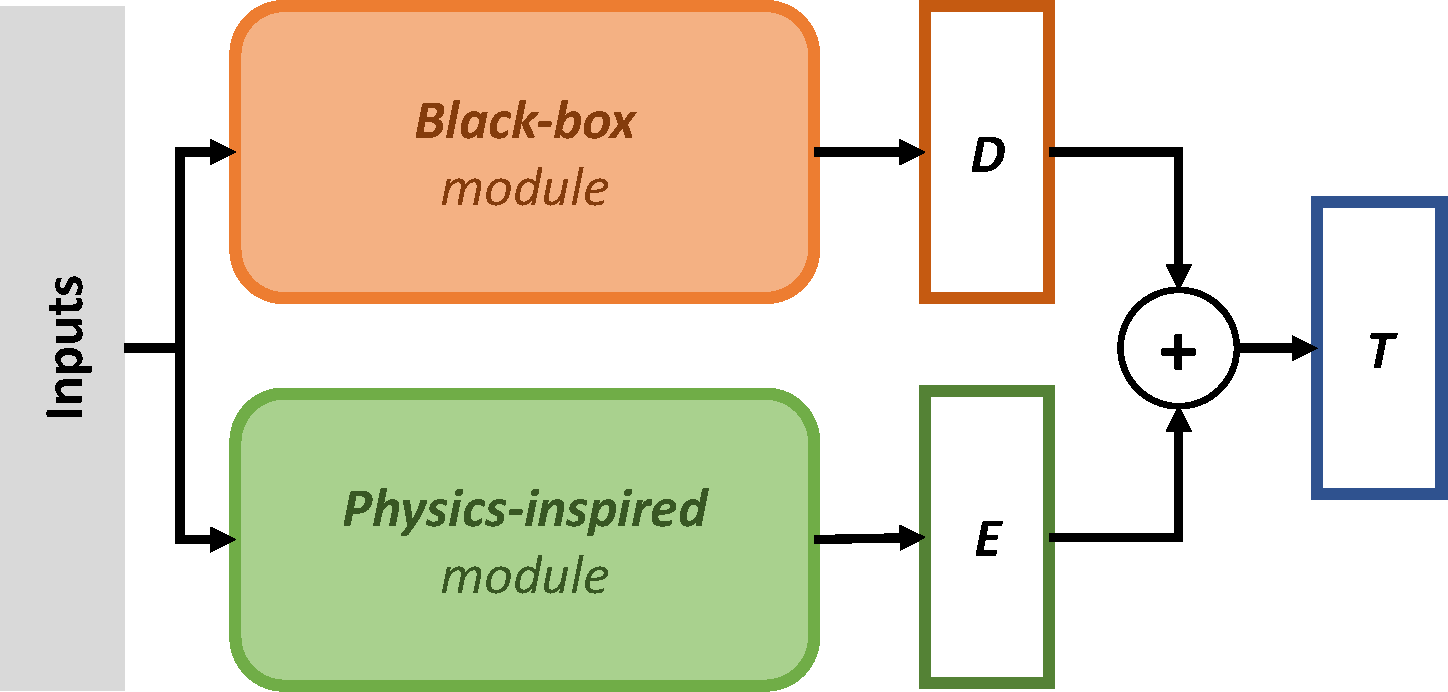

Genau das tun physikalisch konsistente neuronale Netze (PCNNs), wie Sie in unseren jüngsten Veröffentlichungen nachlesen können. Der Kerngedanke besteht darin, das bekannte physikalische Phänomen in einem so genannten physikinspirierten Modul zu erfassen, das parallel zur reinen Blackbox-NN-Architektur läuft. Auf diese Weise können wir sicherstellen, dass das, was wir über die zugrundeliegende Physik wissen, durch das Design respektiert wird, während wir gleichzeitig die komplexe Struktur von NNs nutzen, um komplexe Phänomene zu erfassen, die das von der Physik inspirierte Modul nicht erfassen kann.

Bei der Modellierung der Gebäudetemperatur sorgt das von der Physik inspirierte Modul dafür, dass Heizen zu höheren und Kühlen zu niedrigeren Temperaturen führt und dass niedrige Aussentemperaturen Ihr Gebäude tatsächlich nicht aufheizen können. Und die Leistung ist grossartig - sogar besser als reine NNs. Wir haben festgestellt, dass es hilfreich ist, das Modell zu zwingen, der zugrundeliegenden Physik zu folgen (Abbildung 5, angepasst von hier)! Dieses PCNN ist sich der Auswirkungen von Heizung und Kühlung bewusst und - wenn es zur Steuerung Ihres Gebäudes verwendet wird - kann man darauf vertrauen, dass Sie nicht den ganzen Winter auf Ihrer Couch frieren.

Über Gebäude hinaus

Wir haben Gebäudemodelle als praktischen Fall verwendet, um die Leistung von PCNNs zu untersuchen, aber natürlich können sie auf jede Aufgabe angewendet werden, bei der (Teile) der zugrunde liegenden Physik bekannt sind. Ein wenig Wissen über das System reicht in der Tat aus, um das von der Physik inspirierte Modul zu entwerfen - und man lässt dann das parallel laufende Black-Box-Modul potenziell sehr komplexe unbekannte und/oder nicht modellierte Phänomene erfassen.

Und das Beste daran ist: Sie brauchen nichts weiter zu tun. Sobald das von der Physik inspirierte Modul erstellt wurde, können Sie die Parameter des NN und des von der Physik inspirierten Moduls nahtlos in einem Durchgang zusammen lernen! Wenn Sie interessiert sind, zögern Sie nicht, auf GitHub nachzusehen, wie PCNNs in der Praxis implementiert sind.

Möchten Sie mehr über diesen Forschungszweig erfahren? Sehen Sie sich die anderen Techniken an, die wir verwendet haben, um sicherzustellen, dass neuronale Netze keine Dummheiten machen, hier und hier, und auf meiner Website.