Non basta sembrare intelligenti: come rendere più sicuro l'apprendimento automatico

Dal lancio di ChatGPT appena tre anni fa, l'intelligenza artificiale ha dominato le conversazioni e gli investimenti in misura senza precedenti. Il modello ha infranto tutti i precedenti record di interazione uomo-macchina, diventando la piattaforma più veloce a raggiungere un milione di utenti. Le tendenze attuali indicano che l'IA viene rapidamente integrata in quasi tutti i dispositivi che utilizziamo, dagli smartphone alle lavatrici. Ma sempre più spesso ci si chiede: è sicuro affidarsi così tanto a questa tecnologia, date le sue note carenze?

Sappiamo che i modelli di IA sono inclini alle "allucinazioni": affermazioni che sembrano corrette ma che in realtà sono false. L’aspetto preoccupante è che i modelli di IA sono spesso estremamente sicuri di queste risposte sbagliate o, al contrario, così accondiscendenti da concordare con qualsiasi cosa dica l'utente, solo per renderlo felice. Se sei un utente abituale dei modelli di IA, potresti aver notato tu stesso questo schema. Prima il chatbot fornisce una risposta che sembra convincente, poi ammette che la sua prima affermazione era sbagliata... una correzione che forse arriva un po' troppo tardi .

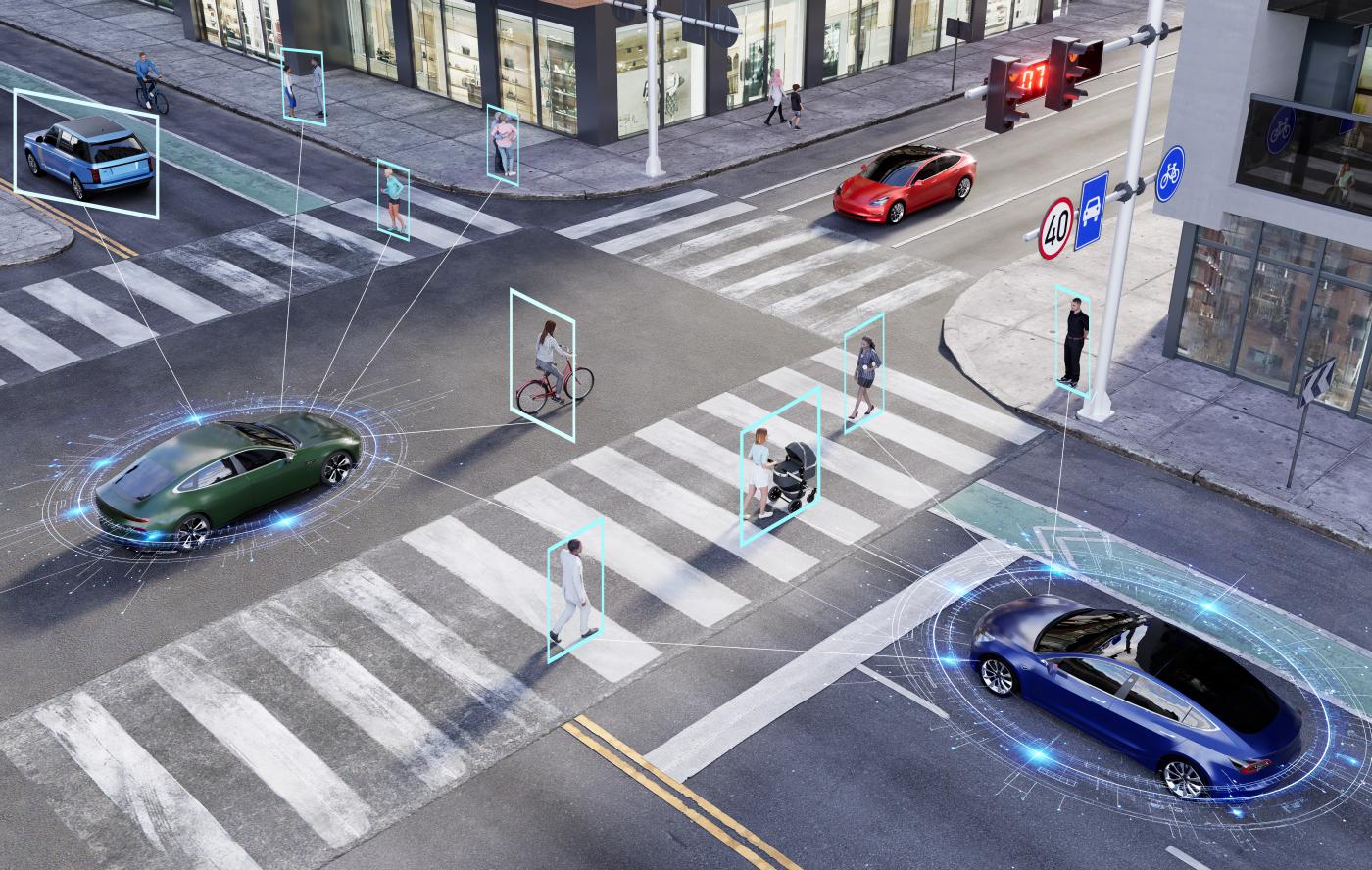

Le stesse preoccupazioni relative all'affidabilità si estendono ai sistemi di IA basati sulla visione, che "vedono" e interpretano le immagini, sia che si tratti di distinguere tra un gatto e un cane, di riconoscere la targa di un'auto a un incrocio o, in futuro, di consentire ai robot domestici o ai veicoli autonomi di accompagnare i bambini a scuola. Sebbene queste applicazioni si basino sulla percezione visiva proprio come gli esseri umani, i sistemi di IA sono molto più fragili.

I modelli di apprendimento automatico, alla base dell'IA, possono essere sorprendentemente vulnerabili anche a piccole alterazioni dei loro input. Questa vulnerabilità è stata osservata per la prima volta nell'apprendimento automatico classico: l'introduzione di una piccola quantità di rumore accuratamente elaborato in un'immagine può indurre il modello a classificarla in modo errato, spesso con un alto grado di sicurezza. Ad esempio, uno strumento di IA potrebbe identificare correttamente un panda in un'immagine, ma dopo aver aggiunto un rumore sottile e creato ad hoc, etichetta erroneamente la stessa immagine come un gibbone. Allo stesso modo, piccole macchie su un segnale di stop possono indurre un'IA a percepirlo come un segnale di limite di velocità.

Questo fenomeno è noto come robustezza avversaria. Anche se può sembrare un difetto minore, le implicazioni sono gravi. Si pensi a un'auto autonoma che interpreta erroneamente un segnale di stop come un segnale di limite di velocità: un errore del genere potrebbe causare incidenti catastrofici. Questa fragilità rende i modelli di IA odierni inaffidabili per le applicazioni critiche per la sicurezza.

Apprendimento affidabile

Durante il mio dottorato di ricerca, ho studiato l'apprendimento automatico attraverso la lente della teoria dei sistemi e del controllo. Si tratta dello stesso campo della matematica e dell'ingegneria che mantiene stabili gli aerei con il pilota automatico, mantiene la temperatura delle nostre stanze, guida le linee di assemblaggio delle automobili e garantisce che i satelliti continuino a orbitare intorno sulle loro traiettorie corrette.

Il suo successo deriva da decenni di rigoroso sviluppo matematico. La motivazione principale della nostra ricerca deriva dai parallelismi recentemente scoperti tra l'apprendimento automatico e il campo consolidato della teoria dei sistemi. Questa connessione ha aperto nuove opportunità per analizzare questi sistemi utilizzando una vasta gamma di strumenti sviluppati nel corso di decenni. Quindi, con la guida del mio relatore, il professor Giancarlo Ferrari Trecate, ho deciso di unire l'apprendimento automatico e la teoria del controllo. Il risultato è stato quello che chiamiamo apprendimento automatico affidabile.

Per "affidabile" intendiamo che un modello di apprendimento automatico dovrebbe comportarsi come previsto, anche in scenari mai visti prima, supportato da solide garanzie matematiche. Questo apre la strada alla possibilità di rendere l'IA interpretabile, limitandone il comportamento in situazioni inesplorate e, in ultima analisi, rendendola sicura da utilizzare in applicazioni critiche.

Naturalmente, "affidabilità" può assumere significati diversi a seconda del contesto. Ad esempio, garantire che un aereo rimanga stabile nonostante le raffiche di vento, costruire modelli di machine learning di un impianto chimico che rispettino le leggi della chimica o progettare un chatbot che non abbia allucinazioni. I ricercatori hanno cercato di rendere l'IA più affidabile utilizzando metodi convenzionali come la limitazione dei parametri dei modelli o la restrizione dei loro output. Sebbene questi approcci possano essere d'aiuto, spesso aggiungono pesanti oneri computazionali o non garantiscono rigorosamente l'affidabilità.

IIl metodo tradizionale per indurre una rete neurale a rispettare determinati vincoli (come le leggi della termodinamica, la stabilità, ecc.) consiste nel mappare il comportamento desiderato attraverso la funzione di costo, ovvero incorporando una penalità (o una ricompensa). La rete cerca quindi di ottimizzare il proprio output in base a questa funzione. Tuttavia, penalizzare questa cosiddetta funzione di ricompensa non significa che in futuro si otterrà la stessa ricompensa.

Per ovviare a questo problema, abbiamo esplorato il concetto di parametrizzazione libera. In termini semplici, ciò significa progettare modelli in modo tale che, indipendentemente da come si regolano i parametri, la rete neurale rispetti automaticamente le proprietà desiderate. L'utente può impostare liberamente i parametri per garantire che l'obiettivo sia soddisfatto in base alla progettazione. Di conseguenza, la rete deve eseguire un numero molto inferiore di calcoli; questo modello è quindi non solo più affidabile, ma anche molto più scalabile ed efficiente dal punto di vista energetico.

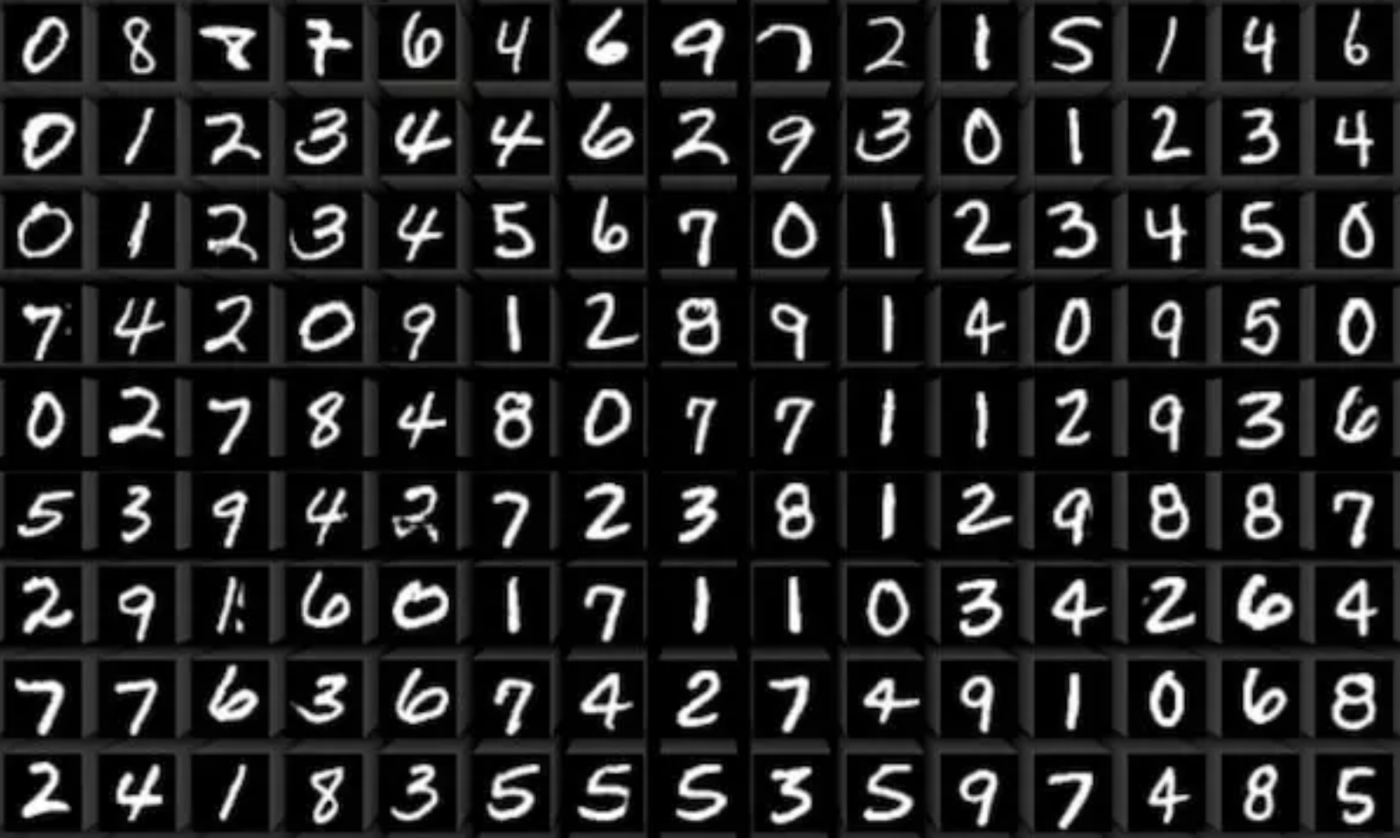

Durante il mio dottorato di ricerca, abbiamo applicato queste idee in diversi contesti. Un esempio è quello di rendere i modelli di IA più robusti nei compiti di classificazione delle immagini. La classificazione delle immagini (insegnare a un modello a etichettare le immagini) è fondamentale per molte applicazioni nel mondo reale: dalla visione nei robot e nelle auto autonome al riconoscimento della scrittura manuale e alla digitalizzazione di libri antichi.

Ma l'affidabilità dell'IA va ben oltre la classificazione delle immagini. Consideriamo qualcosa di quotidiano come la previsione della temperatura nel proprio appartamento. Potrebbe sembrare semplice, ma molti fattori influenzano la temperatura: l'angolo del sole, la disposizione dei mobili, la disposizione delle pareti delle stanze, il tempo esterno e persino la stagione. Scrivere un modello esatto per tutto questo non solo è noioso, ma richiede anche una profonda competenza. Sebbene conosciamo le leggi della termodinamica, non abbiamo un modo semplice per combinarle con i modelli di IA.

È qui che entra in gioco il nostro lavoro. Abbiamo incorporato le leggi fisiche direttamente nella struttura dei modelli di apprendimento automatico, in modo che obbediscano sempre alla fisica, indipendentemente dai parametri. Abbiamo chiamato questi modelli "modelli fisicamente coerenti". I nostri esperimenti hanno dimostrato che tali modelli sono in grado di prevedere in modo affidabile la temperatura degli appartamenti con un anticipo fino a tre giorni, consentendo un migliore controllo del riscaldamento e del raffreddamento. Ciò significa risparmiare energia e, in ultima analisi, aiutare il pianeta. Questo esperimento è stato condotto in una proficua collaborazione con il professor Colin Jones e Loris di Natale.

L'apprendimento affidabile offre un percorso verso un'intelligenza artificiale affidabile che può essere implementata in modo sicuro nella nostra vita quotidiana, anche in applicazioni critiche per la sicurezza. Unendo l'apprendimento automatico alla teoria del controllo, possiamo sfruttare i punti di forza di entrambi: l'espressività e la capacità di generalizzazione dell'intelligenza artificiale, combinate con le rigorose garanzie della teoria del controllo. Crediamo che questo quadro getti le basi per un'intelligenza artificiale interpretabile e sicura.