Kluge Worte reichen nicht aus: Wie wir maschinelles Lernen sicherer machen können

Seit der Einführung von ChatGPT vor nur drei Jahren dominiert künstliche Intelligenz Gespräche und Investitionen in einem noch nie dagewesenen Ausmass. Das Modell brach alle bisherigen Rekorde im Bereich der Mensch-Maschine-Interaktion und wurde zu der Plattform, die am schnellsten eine Million Nutzer erreichte.

Aktuelle Trends deuten darauf hin, dass KI rasch in fast alle Geräte integriert wird, die wir nutzen, von Smartphones bis hin zu Waschmaschinen. Aber zunehmend wird die Frage laut: Ist es angesichts der bekannten Mängel dieser Technologie sicher, sich so stark auf sie zu verlassen?

Wir wissen, dass KI-Modelle anfällig für „Halluzinationen” sind: Aussagen, die richtig klingen, aber tatsächlich falsch sind. Das Beunruhigende daran ist, dass KI-Modelle oft extrem überzeugt von diesen falschen Antworten sind oder andererseits so leichtgläubig, dass sie allem zustimmen, nur um die Nutzer bei Laune zu halten. Wenn Sie regelmässig KI-Modelle nutzen, haben Sie dieses Muster sicher selbst beobachtet: Zuerst gibt der Chatbot eine überzeugend klingende Antwort, und dann stimmt Ihnen dann aber zu, dass seine erste Aussage falsch war. Eine Korrektur, die vielleicht etwas zu spät kommt.

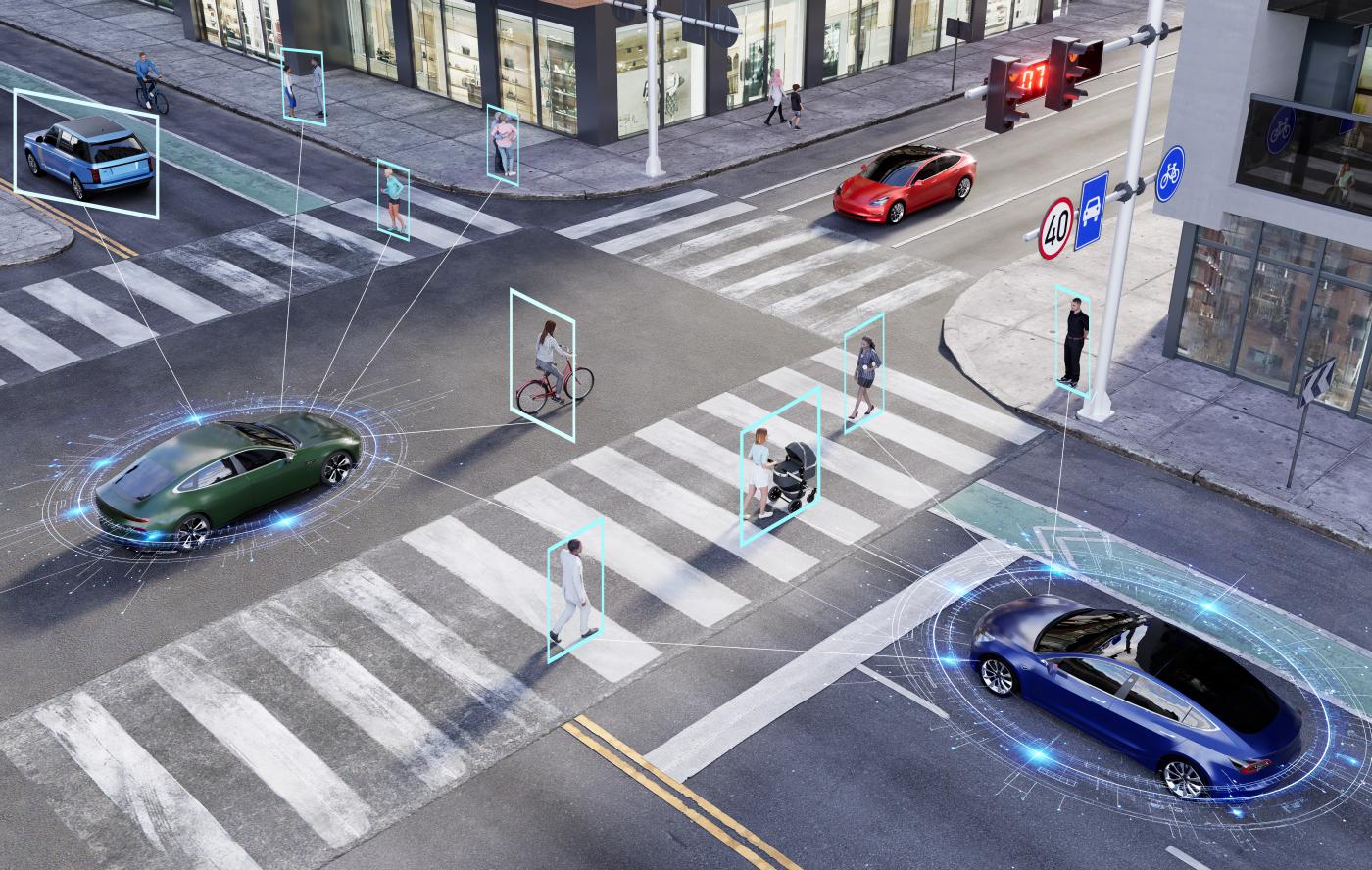

Die gleichen Bedenken hinsichtlich der Zuverlässigkeit gelten auch für bildbasierte KI-Systeme, die Bilder „sehen“ und interpretieren – sei es, um zwischen einer Katze und einem Hund zu unterscheiden, ein Autokennzeichen an einer Kreuzung zu erkennen oder in Zukunft Haushaltsrobotern oder autonomen Fahrzeugen zu ermöglichen, Kinder zur Schule zu bringen. Während diese Anwendungen ähnlich wie Menschen auf visueller Wahrnehmung beruhen, sind KI-Systeme weitaus fehleranfälliger.

Maschinelle Lernmodelle, die Grundlage der KI, können selbst gegenüber geringfügigen Änderungen ihrer Eingaben überraschend anfällig sein. Diese Anfälligkeit wurde erstmals im klassischen maschinellen Lernen beobachtet: Das Einfügen einer winzigen Menge sorgfältig gestalteter Störsignale in ein Bild kann dazu führen, dass das Modell es falsch klassifiziert, oft mit hoher Sicherheit. Beispielsweise könnte ein KI-Tool einen Panda in einem Bild korrekt identifizieren, aber nach dem Hinzufügen subtiler, künstlich erzeugter Störungen das gleiche Bild fälschlicherweise als Gibbon kennzeichnen. In ähnlicher Weise können kleine Flecken auf einem Stoppschild eine KI dazu verleiten, es als Geschwindigkeitsbegrenzungsschild wahrzunehmen.

Dieses Phänomen wird als „adversarial robustness” (feindliche Robustheit) bezeichnet. Auch wenn es sich um einen kleinen Fehler zu handeln scheint, sind die Auswirkungen gravierend. Wenn ein autonomes Auto ein Stoppschild fälschlicherweise als Geschwindigkeitsbegrenzungsschild interpretiert, könnte der Fehler zu katastrophalen Unfällen führen. Diese Anfälligkeit macht die heutigen KI-Modelle für sicherheitskritische Anwendungen unzulässig.

Zuverlässiges Lernen

Während meiner Promotion habe ich mich mit maschinellem Lernen aus der Perspektive der System- und Regelungstechnik beschäftigt. Dies ist dasselbe Gebiet der Mathematik und Ingenieurswissenschaften, das Flugzeuge mit Autopilot stabil fliegen lässt, die Temperatur in unseren Räumen regelt, Fliessbänder in der Automobilindustrie steuert und dafür sorgt, dass Satelliten auf der richtigen Umlaufbahn um die Erde kreisen.

Der Erfolg dieses Gebiets beruht auf jahrzehntelanger rigoroser mathematischer Entwicklung. Die Hauptmotivation für unsere Forschung stammt aus den kürzlich entdeckten Parallelen zwischen maschinellem Lernen und dem etablierten Bereich der Systemtheorie. Diese Verbindung hat neue Möglichkeiten eröffnet, diese Black-Box-Systeme mit einer Fülle von über Jahrzehnte entwickelten Werkzeugen zu analysieren. Unter der Anleitung meines Doktorvaters, Professor Giancarlo Ferrari Trecate, beschloss ich daher, maschinelles Lernen und Regelungstechnik zusammenzuführen. Das Ergebnis war das, was wir als zuverlässiges maschinelles Lernen bezeichnen.

Mit „zuverlässig” meinen wir, dass ein maschinelles Lernmodell sich auch in noch nie dagewesenen Szenarien wie erwartet verhalten sollte, gestützt durch solide mathematische Garantien. Dies eröffnet die Möglichkeit, KI interpretierbar zu machen, ihr Verhalten in unbekannten Situationen zu begrenzen und sie letztendlich für den Einsatz in kritischen Anwendungen sicher zu machen.

Natürlich kann „Zuverlässigkeit“ in verschiedenen Kontexten unterschiedliche Bedeutungen haben. Zum Beispiel kann es darum gehen, sicherzustellen, dass ein Flugzeug trotz Windböen stabil bleibt, maschinelle Lernmodelle für eine Chemiefabrik zu entwickeln, die weiterhin den Gesetzen der Chemie gehorchen, oder einen Chatbot zu entwerfen, der keine Halluzinationen hat. Forscher haben versucht, KI zuverlässiger zu machen, indem sie herkömmliche Methoden wie die Einschränkung der Parameter von Modellen oder die Beschränkung ihrer Ergebnisse verwendet haben. Diese Ansätze können zwar hilfreich sein, führen jedoch oft zu einer hohen Rechenlast oder können die Zuverlässigkeit nicht rigoros garantieren.

Die traditionelle Methode, um ein neuronales Netzwerk dazu zu bringen, festgelegte Einschränkungen (wie die Gesetze der Thermodynamik, Stabilität usw.) einzuhalten, besteht darin, das gewünschte Verhalten durch die Kostenfunktion abzubilden, d. h. eine Strafe (oder Belohnung) einzubauen. Das Netzwerk versucht dann, seine Ausgabe entsprechend dieser Funktion zu optimieren. Aber wenn man diese sogenannte Belohnungsfunktion bestraft, heißt das nicht, dass man in Zukunft die gleiche Belohnung bekommt.

Um dieses Problem zu lösen, haben wir das Konzept der freien Parametrisierung untersucht. Einfach ausgedrückt bedeutet dies, dass Modelle so gestaltet werden, dass das neuronale Netzwerk unabhängig von der Einstellung der Parameter automatisch die gewünschten Eigenschaften berücksichtigt. Infolgedessen muss das Netzwerk weitaus weniger Berechnungen durchführen. Dieses Modell ist daher nicht nur zuverlässiger, sondern auch weitaus skalierbarer und energieeffizienter.

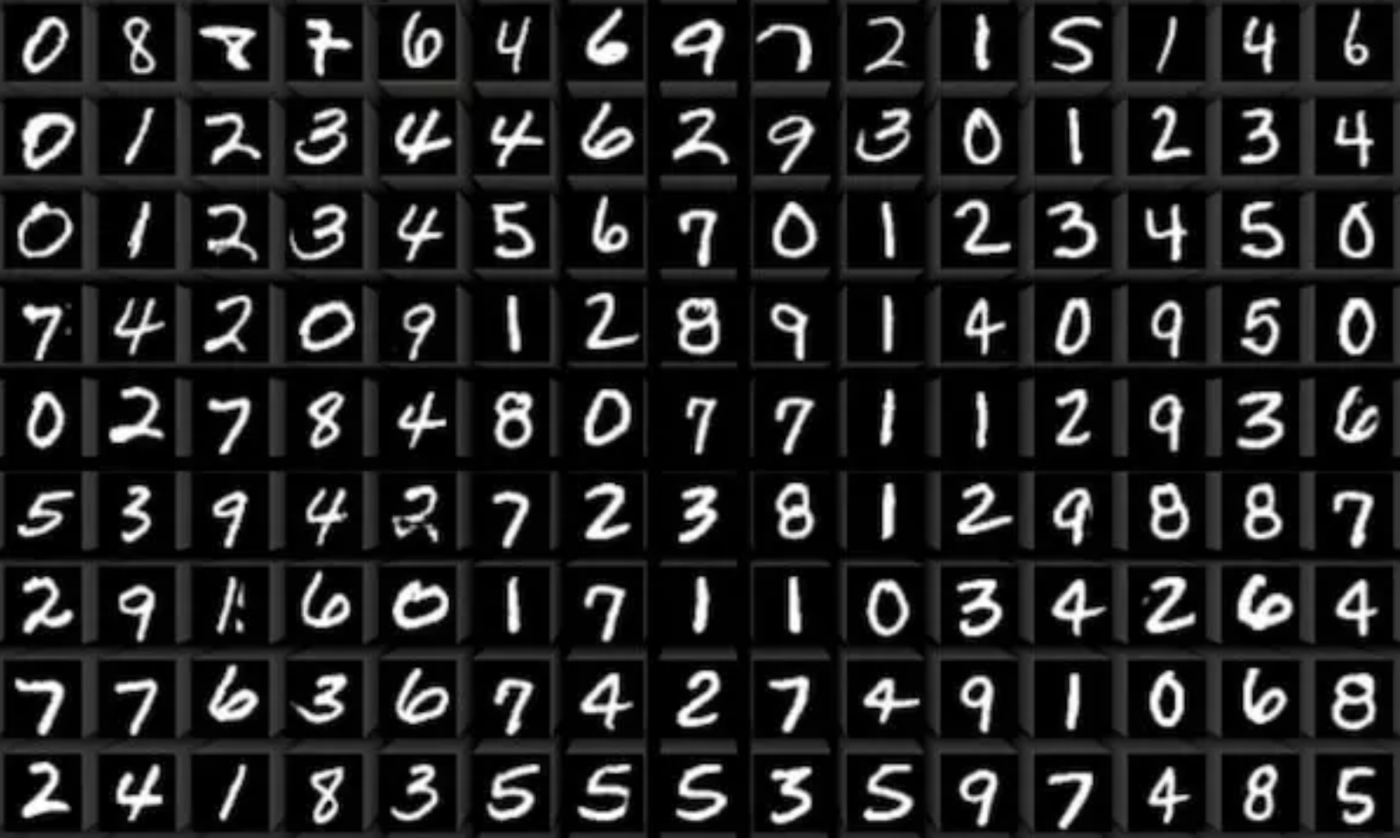

Während meiner Promotion haben wir diese Ideen in mehreren Frameworks angewendet. Ein Beispiel ist die Verbesserung der Robustheit von KI-Modellen bei Bildklassifizierungsaufgaben. Die Bildklassifizierung ist für viele Anwendungen in der Praxis von zentraler Bedeutung: von der Bildverarbeitung in Robotern und autonomen Fahrzeugen bis hin zur Handschrifterkennung und Digitalisierung alter Bücher.

Zuverlässige KI geht weit über die Bildklassifizierung hinaus. Denken Sie an etwas Alltägliches wie die Vorhersage der Temperatur in Ihrer Wohnung. Das mag einfach klingen, aber viele Faktoren beeinflussen die Temperatur: der Winkel der Sonne, die Platzierung der Möbel, die Aufteilung der Räume, das Wetter draussen und sogar die Jahreszeit. Ein genaues Modell für all dies zu erstellen, ist nicht nur mühsam, sondern erfordert auch fundiertes Fachwissen. Wir kennen zwar die Gesetze der Thermodynamik, haben aber keine einfache Möglichkeit, sie mit KI-Modellen zu kombinieren.

Hier kommt unsere Arbeit ins Spiel. Wir haben physikalische Gesetze direkt in die Struktur von Modellen für maschinelles Lernen eingebettet, sodass diese unabhängig von den Parametern stets den Gesetzen der Physik folgen. Wir haben diese Modelle als physikalisch konsistent bezeichnet. Unsere Experimente haben gezeigt, dass solche Modelle die Temperatur in Wohnungen bis zu drei Tage im Voraus zuverlässig vorhersagen können, was eine bessere Steuerung der Heizung und Kühlung ermöglicht. Das bedeutet Energieeinsparungen und letztlich einen Beitrag zum Schutz unseres Planeten. Dieses Experiment wurde in Zusammenarbeit mit Professor Colin Jones und Loris di Natale durchgeführt.

Zuverlässiges Lernen bietet einen Weg zu einer vertrauenswürdigen KI, die sicher in unserem täglichen Leben eingesetzt werden kann, selbst in sicherheitskritischen Anwendungen. Durch die Verschmelzung von maschinellem Lernen und Regelungstheorie können wir die Stärken beider Bereiche nutzen: die Ausdruckskraft und Generalisierungsfähigkeit der KI in Kombination mit den strengen Garantien der Regelungstechnik. Wir glauben, dass dieses Framework die Grundlage für eine interpretierbare und sichere KI bildet.